Faire tourner un LLM directement sur votre téléphone sans internet avec MLC LLM

Introduction MLC LLM est une solution universelle qui permet de déployer n'importe quel modèle de langage sur un ensemble diversifié de plateformes matérielles et d'applications natives. Grâce à un cadre de travail productif, cette solution offre une optimisation des performances pour chaque cas d'utilisation. Tout fonctionne localement, sans serveur, et est accéléré par les GPU locaux sur votre téléphone et votre ordinateur portable. Pour en savoir plus, consultez leur dépôt GitHub. Essayer

PandIA (Page 2)

MLC LLM

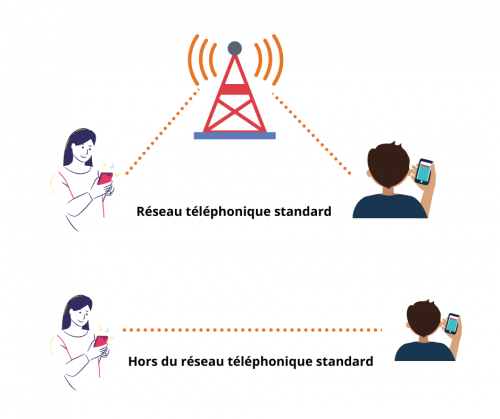

Comment communiquer sans Internet ? - Rebelle

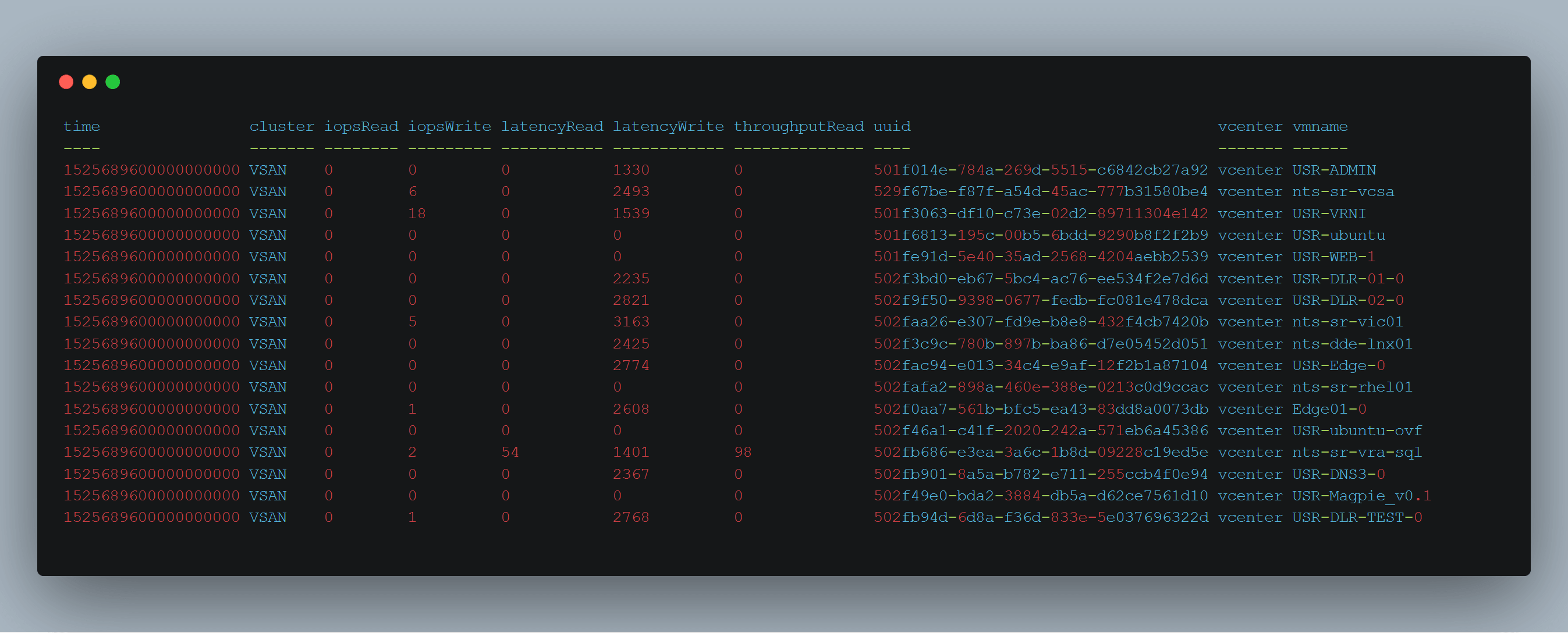

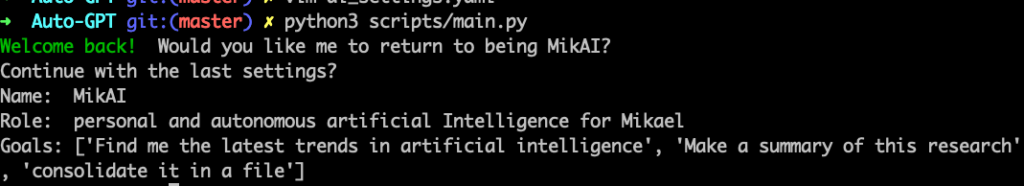

PART 2 : Comment disposer de votre propre LLM sur votre machine ? - MyVMworld

Running Large Language Models Natively on Mobile and Laptops

PART 2 : Comment disposer de votre propre LLM sur votre machine ? - MyVMworld

MLC LLM: Enabling LLMs To Be Deployed Across Multiple Devices

Pourquoi utilisez-vous votre LLM local ? : r/LocalLLaMA

3 astuces pour améliorer la connexion internet mobile

MLC Bringing Open Large Language Models to Consumer Devices

C'est quoi un LLM ? Comment fonctionnent les moteurs de ChatGPT, Google Bard et autres ?

PART 2 : Comment disposer de votre propre LLM sur votre machine ? - MyVMworld

/cloudfront-eu-central-1.images.arcpublishing.com/ipmgroup/BS5JWXDER5BMZJL63BRYX7QQIA.jpg)